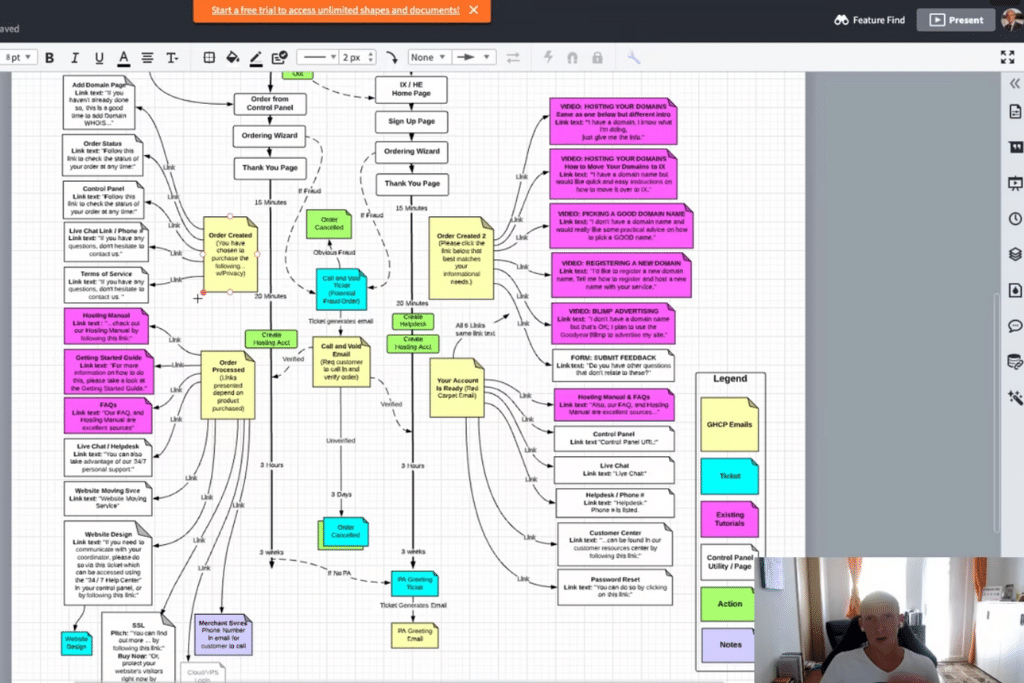

Die im Video erwähnten Tools: Und natürlich der klassische Block + Stift. Nachdem ich persönlich kein großer Freund von toten Bäumen bin, skizziere ich die ersten Drafts von Workflows auf meinem iPad mit Apple Pencil und der App “Good Notes” (verfügbar im App Store). Erfahrungsgemäß wachsen die Workflow-Ketten sehr rasch an. Daher beginne ich wirklich mit dem technisch absoluten Minimum. Die eingesetzte Software soll in diesem ersten Schritt definitiv NICHT im Mittelpunkt stehen.

Im ober angeführten Video finden Sie eine Schritt-für-Schritt Anleitung für die Erstellung des Workflows, sowie mögliche Tools für die Umsetzung. In den folgenden Schritten möchte ich Ihnen noch zusätzliche Informationen zu den einzelnen Teilschritten mitgeben.

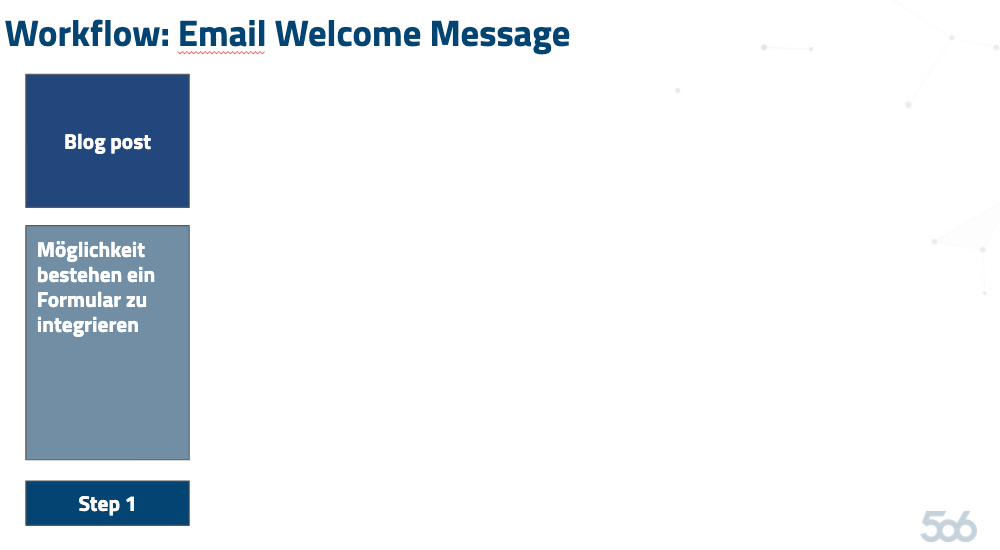

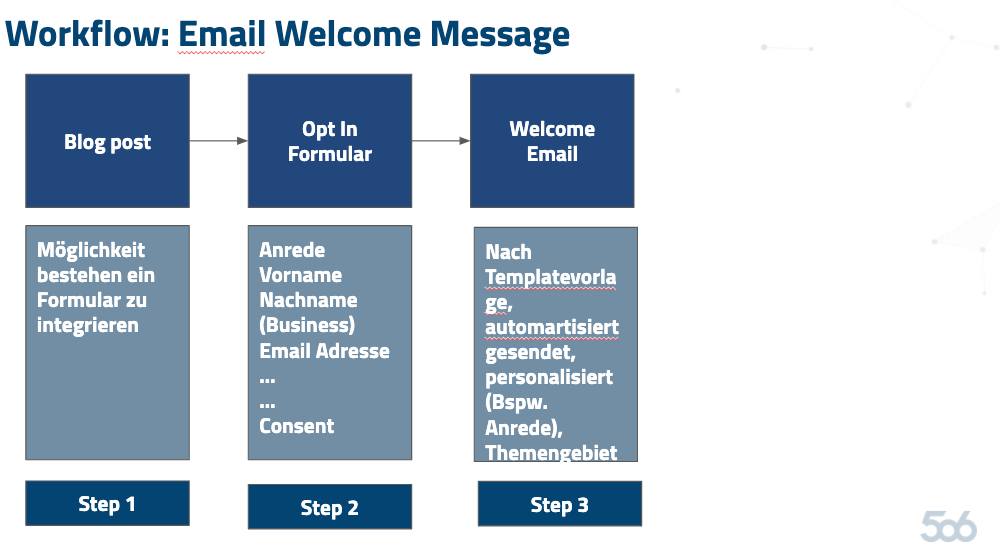

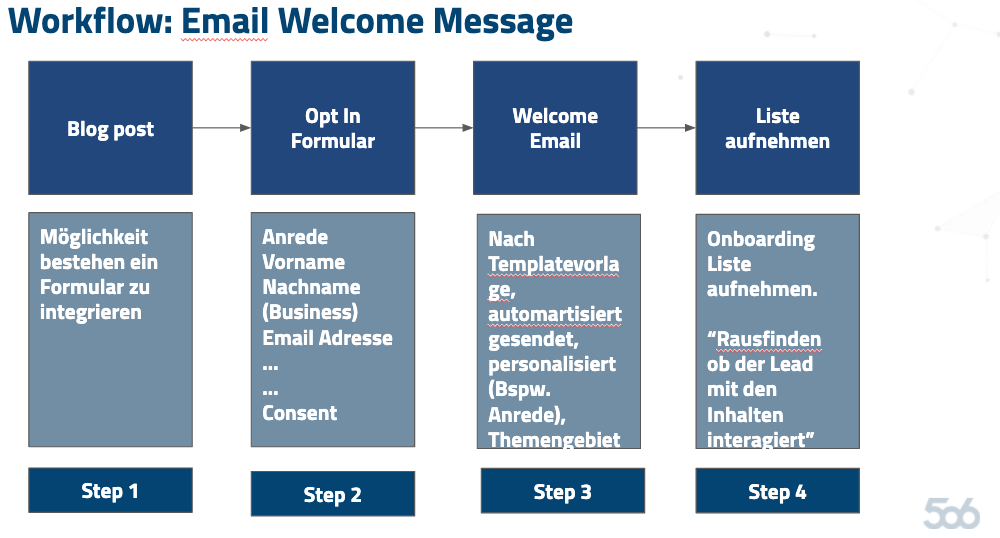

Schritt 1: Blog Post

Schritt 2: Opt-In Formular

In diesen zweiten Schritt geht es um die Definition des eigentlichen Opt-In Formulars und die jeweiligen Formularfelder. Natürlich ist die angeführte Version in einer Minimalausprägung. Im Video erwähnten Beispiel werden folgende Formularfelder abgefragt: Diese Formularfelder sind sehr stark davon abhängig, ob Sie in B2B- oder B2C-Bereich tätig sind. Für B2B sollte man zumeist explizit nach der Firmen Email Adresse nachfragen, um so die Einreichungen von @gmx.at, @gmail.com etc. zu minimieren. Eine weitere Ausbaustufe der Formulare wäre die sukzessive Anreicherung der Informationen eines Kontakts. Sollte ein bestehender Lead zum 2. Mal ein Formular ausfüllen, so kann man beispielsweise ergänzende Fragen stellen, wie: “Anzahl der MItarbeiter in Ihrem Unternehmen” mit einem Dropdown.

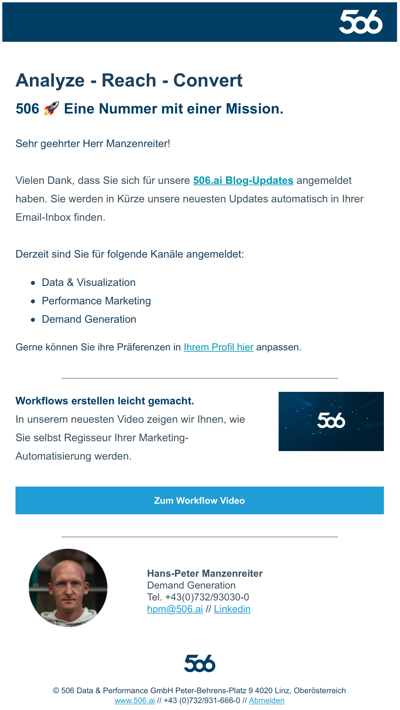

Schritt 3: Welcome Email

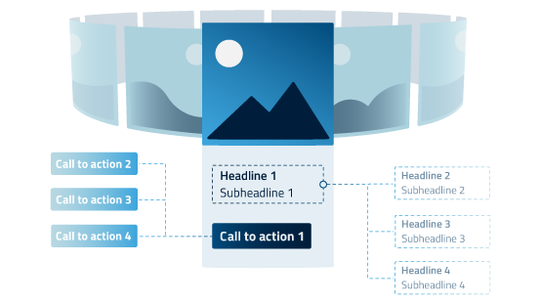

HINWEIS: An dieser Stelle möchte ich noch erwähnen, dass Sie ein Double Opt-In Email aussenden sollten, um sicherzustellen, dass Sie valide & rechtskonforme Eintragungen bespielen. Zur Information: dies ist meine persönliche Meinung und keine Rechtsauskunft. Bitte unbedingt mit Ihrem Anwalt oder Ihrer Rechtsabteilung klären! Für die Welcome Email benötigen Sie eine Templatevorlage. Es empfiehlt sich ein gebrandetes Email Template zu erstellen, welches allgemeingültig in Ihrem Unternehmen verwendet werden kann. Beispielvorlage eines Welcome Emails:

Elemente in diesem Welcome Email: Darüber hinaus sollten Sie den Betreff der ersten Email einem Test unterziehen. Stichwort: Welche Betreffzeile führt zur höchsten Öffnungsrate bei Ihren Leads? Selbstverständlich gibt es hier noch weitere Ausbaustufen und inhaltliche Empfehlungen. Sie können beispielsweise erwähnen, wie oft ein Newsletter versendet wird. Hier haben wir eine ganz klare Empfehlung: diese Inhalte müssen getestet werden.

Schritt 4: In Onboarding-Liste aufnehmen

Es empfiehlt sich, dass Ihr neuer Lead zuerst in einer Liste namens “Newsletter Onboarding” oder dergleichen platziert wird. Hier können Sie sehr spezifisch messen, wie Ihre neuen Lead-Kontakte mit den Inhalten interagieren (oder nicht interagieren).

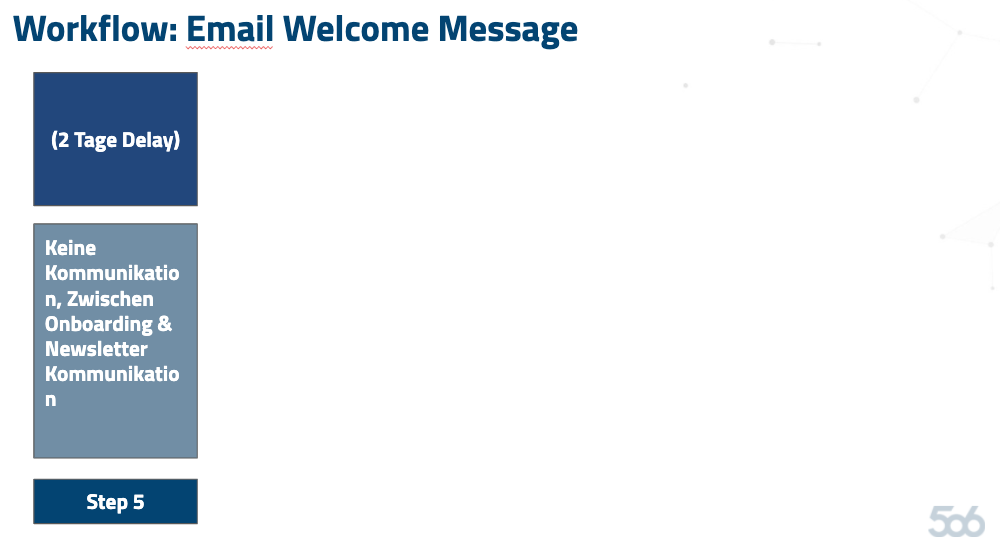

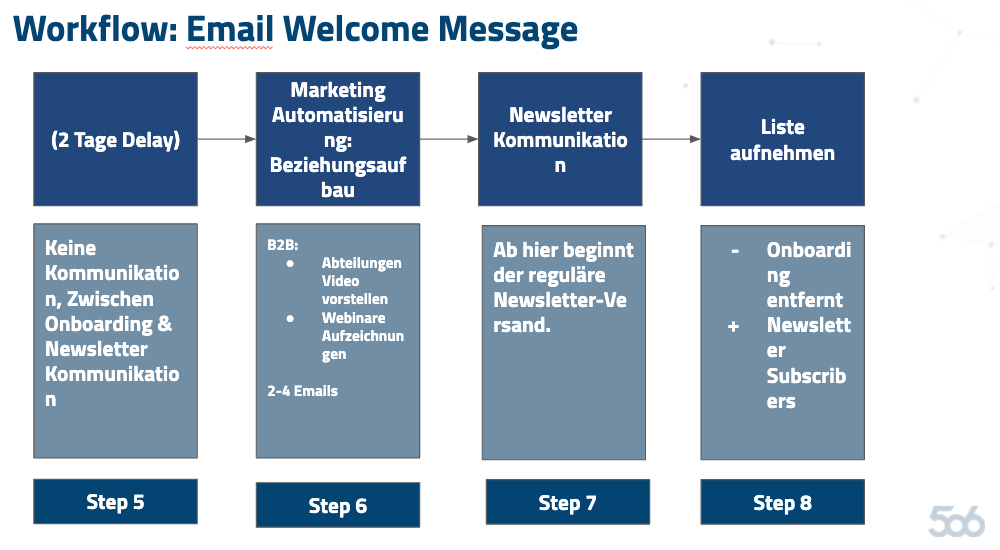

Schritt 5: 2 Tage Delay

Beim Thema “Welcome Messages” scheiden sich die Geister – und wie so oft: es kommt auf Ihre Zielgruppe darauf an. Wenn Sie im B2B-Bereich tätig sind, müssen Sie in der Kommunikation ganz anders auftreten als vglw. Im B2C-Bereich. Für B2B empfehlen wir eine 2-Tages Pause einzulegen, bevor der nächste Versand stattfindet. Bei B2C sollte man tendenziell öfter und früher kommunizieren, um nicht in Vergessenheit zu geraten.

Schritt 6: Marketing Automatisierung & Beziehungsaufbau

Bevor Sie nun beginnen, Ihren neuen Lead mit Newsletter-Ausgaben zu beispielen, empfiehlt es sich (unabhängig ob B2B oder B2C), zuerst 2-4 Willkommens-Ausgaben auszusenden um Beziehungsaufbau zu betreiben. In diesen Willkommens-Ausgaben fokussieren Sie sich stark darauf, Ihr Unternehmen vorzustellen – aber Achtung: KEIN SALES in den Inhalten! Wenn Sie im B2B-Bereich tätig sind, können Sie beispielsweise Ihre Abteilungen mittels Videos vorstellen lassen oder vergangene Webinar-Aufzeichnungen empfehlen (Stichwort: Bestehende Inhalte neu verwenden).

Schritt 7: Newsletter Kommunikation

Nun beginnt der eigentlich Versand Ihrer Unternehmens-Newsletter. In unserem Beispiel nehmen wir an, dass es sich um einen standardmäßigen Newsletterversand handelt.

Schritt 8: In separate Liste aufnehmen

Parallel dazu wird Ihr neuer Lead aus der “Onboarding Liste” entfernt und in Ihre allgemeine Newsletter Liste aufgenommen.

Der dargestellte Workflow ist natürlich in einer Minimalform. Meine Hauptintention lag eher darin aufzeigen, wie Sie eine Workflow-Kette für Ihr Unternehmen gestalten können. Versuchen Sie sich selbst und gestalten Sie einen ersten möglichen Workflow für Ihr Unternehmen. Gerne helfe ich Ihnen natürlich persönlich aus, wenn Sie Fragen dazu haben. Hier finden Sie meinen Kalender und Verfügbarkeiten.

So starten Sie mit der Workflow-Gestaltung

Tools zur Erstellung von Workflow-Ketten

Die 8 Workflow Schritte im Detail erklärt

Schritt 1: Technische Gegebenheiten

Schritt 2: Das Opt-In Formular

Schritt 3: Welcome Email

Schritt 4: Liste aufnehmen

Schritt 5: 2 Tage Delay

Schritt 6: Marketing Automatisierung: Beziehungsaufbau mit Ihrem neuen Lead

Schritt 7: Newsletter Kommunikation

Schritt 8: Aufnahme in allgemeine Listen

Fazit

Monat: April 2020

User Interfaces

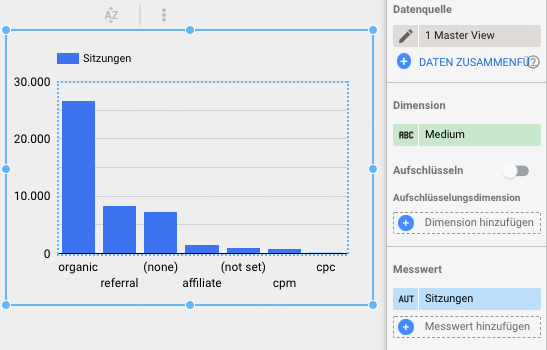

Das Google Data Studio verfügt über eine benutzerfreundliche Oberfläche, die nach einer kurzen Eingewöhnungszeit einfach und schnell zu bedienen ist. Nachdem man sich mit seinem Google Account in das Programm eingeloggt hat, wird einem die Startseite vom Data Studio angezeigt. Hier findet man neben einem Suchfeld und der Aufschlüsselung der bisher erstellten Reports auch ein Feld mit “+ Neue Datei erstellen”. Über den bereits erstellten Reports finden sich Vorlagen und Beispiele, die man entweder direkt verwenden und anpassen oder als Inspiration in den eigenen Report einfließen lassen kann. Drückt man nun das Symbol +, um einen eigenen Bericht zu starten, so landet man auf auf einer leeren Berichtsseite, auf der zuerst die Datenquelle konfiguriert werden muss. Grundsätzlich kann jede mögliche Datenquelle an das Data Studio angebunden werden, sofern es einen Connector von Google selbst oder einen externen Anbieter dafür gibt. Für externe Anbieter fallen jedoch meist Zusatzkosten an. Wir arbeiten mit Supermetrics, wodurch unter anderem die Anbindung über Facebook, Instagram, LinkedIn, Adform und Display & Video360 möglich ist und machen damit sehr gute Erfahrungen.

Nach der Konfiguration der Datenquelle können Tabellen, Säulen-, Kreisdiagramme, Zeitreihendiagramme und vieles mehr erstellt werden. Alle Visualisierungen folgen dem gleichen Muster und bestehen aus Dimensionen und Messwerten, welche man per Drag and Drop festlegen kann: Dimensionen sind Zeilen mit Buchstaben und werden mit ABC im Data Studio gekennzeichnet. Hier kann man beispielsweise Kampagnennamen, Line Item Namen, Städte und vieles mehr als Dimension festlegen. Anschließend müssen ein oder mehrere Messwert(e) festgelegt werden. Hier kann man klassische Kennzahlen wie Impressionen, Klicks, CTR, CPM oder CPC hinzufügen. Würde man beispielsweise ein Balkendiagramm einfügen wollen, sind die Dimensionen auf der X-Achse zu sehen, der Messwert wird entlang der Y-Achse aufgetragen und gibt visuell beispielsweise die Anzahl der Sitzungen an.

Neben der Auswahl der Daten kann auch der Reiter “Stil” ausgewählt werden. Hier kann man das jeweilige Diagramm optisch bearbeiten. Es können nicht nur Farben und Schriftgrößen sowie Schriftarten, sondern auch Dezimalstellen und Zeilenumbrüche formatiert werden.

Anzeigemodus/Bearbeitungsmodus

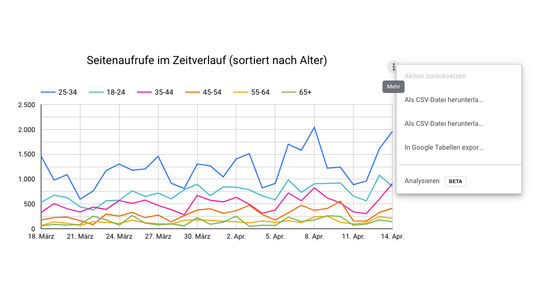

Ein wichtiges Know How betrifft die Unterscheidung zwischen Bearbeitungs- und Anzeigemodus. Im Bearbeitungsmodus kann man wie der Name bereits vermuten lässt Tabellen, Grafiken und Schriften bearbeiten, im Anzeigemodus zeigt sich der Bericht in einer glatten Oberfläche, in der keine Änderungen in den Daten und am Stil vorgenommen werden können. Hinzugefügte Filter- oder Zeitraum-Steuerungen können nur im Anzeigemodus bedient werden. Darüber hinaus kann man durch Mouseover an einem Diagramm Interaktionen im Anzeigemodus durchführen. Beispielsweise kann hier nach Messwerten sortiert, das einzelne Diagramm als CSV heruntergeladen oder in eine Google Tabelle exportiert werden.

Filter/Filtersteuerung

Etwas verwirrend kann die Benennung der einzelnen Funktionen im Data Studio sein. So gibt es beispielsweise eine Funktion “Filtersteuerung” und eine weitere, welche nur den Namen “Filter” trägt. Diese beiden Möglichkeiten haben aber nicht zwingend etwas miteinander zu tun.

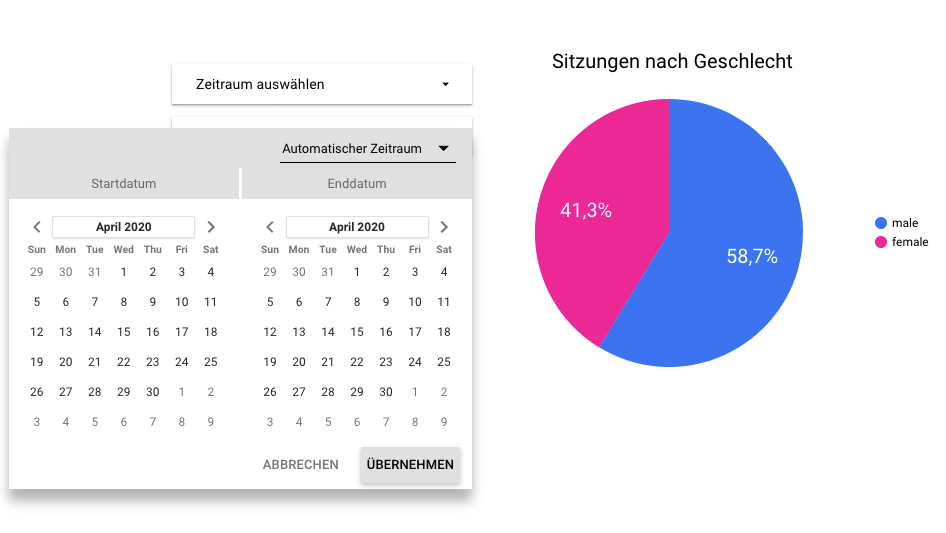

Die Filtersteuerung ist ein eigenständiges Feld, welches man seinem Bericht hinzufügen kann. Es ermöglicht dann die Filterung des Berichtes oder der Seite im Anzeigemodus. Dafür können alle möglichen Felder aus der Datenquelle verwendet werden. Mögliche Beispiele wären hier Filter für bestimmte Kampagnen, bestimmte Line Items oder bestimmte Städte. Eine weitere Filtersteuerung betrifft das Datum. Dieses kann als Feld hinzugefügt und für den relevanten Zeitraum eingestellt werden. Später im Anzeigemodus können dann dynamisch beliebige Zeiträume ausgewählt werden. Nach der Auswahl der Tage verändern sich die Diagramme automatisch und zeigen nur jene Daten an, welche in diesem Zeitraum liegen. Filtersteuerungen können auf Seiten-, aber per Rechtsklick auch auf Berichtsebene eingestellt werden. Dadurch können beispielsweise alle Diagramme des Berichts mit einem Klick auf den ausgewählten Zeitraum sowie die auszuwertende Kampagne eingestellt werden.

Die Funktion Filter kann nach Klick auf ein Diagramm unter Daten hinzugefügt werden. Hier werden wie der Name bereits verrät Filter für die jeweilige Tabelle oder die jeweilige Grafik erstellt. Möchte man beispielsweise nicht alle Line Items einer Kampagne auswerten, sondern nur jene aus einer bestimmten Phase der Customer Journey, so fügt man einen Filter hinzu. Diesen muss man, nachdem man ihn benannt hat, einem Feld zuweisen, worauf der Filter angewendet werden soll. Anschließend kann aus unterschiedlichen Optionen wie “Beginnt mit, Enthält, Größer/Kleiner als” etc. ausgewählt und der Filter letztendlich erstellt werden. Einen Filter kann man nach dessen Erstellung für sämtliche Berichte und Diagramme anwenden. Nach einer gewissen Zeit wird man also eine Vielzahl an unterschiedlichen Filtern für sämtliche Datenquellen und Inhalte angesammelt haben. Eine sinnvolle Benennung dieser ist also essentiell.

Berechnete Felder

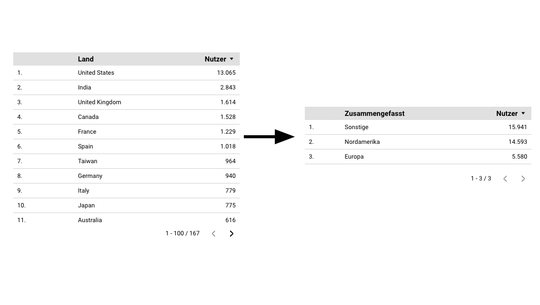

Neben der Visualisierung der reinen Daten aus unterschiedlichen Kampagnen lässt das Google Data Studio auch die Berechnung von neuen Feldern zu. Dafür muss ein Nutzer berechtigt sein, die jeweilige Datenquelle zu bearbeiten. Ausgehend von einem bereits existierenden Feld kann man nicht nur einfache Grundrechnungsarten, sondern auch komplexe, mehrere Variablen umfassende Berechnungen durchführen. Neben der Möglichkeit von Rechenoperationen gibt es unter anderem auch noch die Option der Regular Expressions: Hier kann man beispielsweise bereits bestehende Feldnamen in einer Tabelle durch andere Namen ersetzen. Darüber hinaus kann man mit dem Befehl “CASE” einen Fall eröffnen, der eine Wenn-Dann-Bedingung aufstellt. Ein einfaches Beispiel wäre folgendes Szenario:

CASE

WHEN REGEXP_MATCH(Land, “(United States|Canada)”) THEN “Nordamerika”

WHEN REGEXP_MATCH(Land, “(France|Germany|Italy|United Kingdom|Spain)” ) THEN “Europa”

ELSE “Sonstige”

END

Wenn das Land USA, Kanada oder Mexiko heißt, dann soll das System diese zu Nordamerika zusammenfassen. Findet das System Länder mit dem Namen England oder Frankreich, so soll diese Gruppe Europa heißen. Andere Regionen werden unter dem Begriff Sonstige zusammengefasst.

Anwendungsfälle wären hier die Berechnung von Summen, die Darstellung von Tabellen in übersichtlicherer Form und die Berechnung von Durchschnittswerten, wie CPM oder CPC, falls diese nicht bereits vom Connector automatisch berechnet wurde.

Pros and Cons

Am Ende sollte dieser Blogbeitrag noch mit einer kleinen Bilanz über die Vor- und Nachteile des Google Data Studios abschließen. Als ersten klaren Vorteil kann man die Integration von vielen unterschiedlichen Datenquellen in einem Report sehen. So ist es nicht mehr notwendig jede DSP einzeln aufzurufen, sondern man kann mithilfe eines voreingestellten Berichts alle wichtigen Messwerte der Kampagne auf einen Blick betrachten. Ein weiterer Vorteil ist die Funktionalität hinsichtlich Filter und Berechnung der Felder. Mit diesen Optionen ist es möglich in kurzer Zeit die gewünschten Daten in die richtige Form zu bringen. Ebenso kann ein Report, wenn er einmal erstellt ist, mit relativ wenig Zeitaufwand wieder für einen neuen Zeitraum upgedatet werden.

Klare Schwächen hat das Google Data Studio in der kollaborativen Arbeit, sprich in der Erarbeitung eines Berichts zusammen mit Kollegen. Zwar ist es möglich jemand anderen für einen Report freizugeben, jedoch passieren durch die lange Ladezeit der einzelnen Diagramme die Änderungen nicht in Echtzeit. Auch die gemeinsame Nutzung einer Datenquelle kann zu Verwirrungen führen: Obwohl man mit einer Datenquelle zwei unterschiedliche Berichte erstellt, sind die Datenquelle als eigene Instanz zu sehen. Berechnet ein Mitarbeiter also ein Feld neu oder benennt es um, so verändern sich diese Variablen, sofern verwendet, auch in anderen Berichten, in der diese Datenquelle verwendet wurde, ohne dass diese Reports bearbeitet wurden. Ein weiterer Nachteil besteht in der Verbindung zu gewissen Datenquellen. Zwar lässt das Programm die Verbindung zu all jenen Datenquellen zu, die zur Verfügung stehenden Felder sind jedoch begrenzt. Laut Google Support sind einige Anbindungen zu Datenquellen noch nicht vollständig ausgereift – so ist es auch wenig überraschend, dass man in der jeweiligen DSP selbst mehr auszuwertende Felder zur Verfügung hat als im Google Data Studio. Ein letzter Nachteil besteht in der Kombination von unterschiedlichen Datenquellen. So ist es zum Beispiel nicht möglich diverse Social Media Kanäle in einer Tabelle/Grafik darzustellen. Dies ist gerade bei kanalübergreifenden Kampagnen sehr schade, da der Gesamtüberblick ausbleibt.

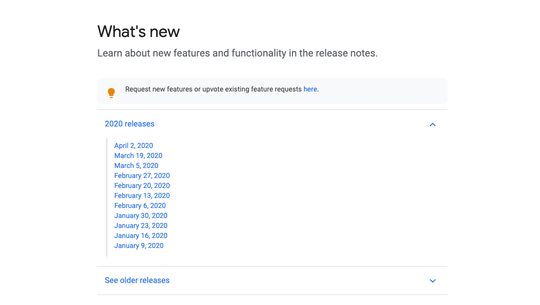

Will man über Neuigkeiten und Verbesserungen des Google Data Studios Bescheid wissen, so sollte man in regelmäßigen Abständen die Support-Website von Google Data Studio aufrufen. Hier werden Neuerungen und Versionshinweise aufgelistet. Wichtig anzumerken ist hier, dass die englische Übersetzung dieser Seite meist eine bis zwei Versionen im Vorsprung ist.

Fazit

Das Fazit von 506 fällt aufgrund der einfachen Bedienbarkeit und der zahlreichen Visualisierungsmöglichkeiten durchaus positiv aus. Die langen Ladezeiten und fehlenden Felder bei einigen Datenquellen lassen jedoch Raum für Verbesserungen und Optimierungen.

Abschließend kann man sagen, dass automatisiertes Reporting per Knopfdruck also kein irrationaler Wunschgedanke ist, sondern durch Google Data Studio eine mögliche Realität sein kann. Die Arbeit des Projektmanagers in Bezug auf Fehlerbehebungen, Kontrolle der Daten und Interpretation dieser ist jedoch nicht durch ein automatisiertes Reporting zu ersetzen.

Online-Shop – das Allheilmittel?

Die Regierungsbeschlüsse zu Covid-19 vom 13. März 2020 zwingen alle Geschäfte, die nicht der Grundversorgung unterliegen, geschlossen zu bleiben. Dabei trifft es jene besonders hart, die den größten Teil ihres Umsatzes f2f erwirtschaften. Bei Unternehmen, mit angebundenen Online-Shop, führt die fehlende stationäre Beratung zu großen Schwierigkeiten in der Produkt-Kommunikation.

Ist ein Produkt erklärungsbedürftig oder individuell abgestimmt auf den Kunden, benötigt es oft zusätzliche Beratung vor Ort, auch wenn der Kauf digital abgewickelt wird. Beispiele für solche Produkte sind Fahrräder oder Ski. Dasselbe gilt auch, wenn die Auswahl des Produktsortiments den Kunden überfordern kann. Dadurch kann selbst bei vorhandenen Online-Shop die Conversion unter den Covid-19-Maßnahmen leiden.

Es geht nicht ohne Entscheidungshilfe

Hier kann Online-Beratung den entscheidenden Mehrwert für den Kunden bringen. Wie dies schnell und sauber umgesetzt werden kann, zeigen die drei nachfolgenden Konzepte von führenden Unternehmen auf ihrem Sektor. Dies führte zu einer Stärkung der Kundenbeziehung und hilft den Unternehmen besser durch diese Krise zu kommen.

1. Ikea Möbelvertrieb OHG

Unter der Headline “Kostenlose Online Expertenplanung” bietet der schwedische Möbelhändler seinen (potenziellen) Kunden weiterhin Beratung und Fachexpertise.

Planungsthemen, die bis jetzt von Fachpersonal vor Ort übernommen wurden, sind hier kategorisiert und durch klare Call-to-Actions dargestellt. Nach Auswahl des Themenbereiches erfolgt entweder eine Weiterleitung zu spezifischen Fragen oder die Auswahl eines Termins für ein persönliches Gespräch mit einem Berater via Telefon und Bildschirmübertragung.

2. OBI Group Holding

Der Baumarkt setzt in Puncto Online-Beratung auf seine App “heyOBI”. Diese bietet kostenlose Beratung via Nachricht, Telefon oder Videotelefonie, wobei der Kunde eine für ihn passende Form der Beratung auswählen kann. Grundvoraussetzung ist ein OBI Kundenkonto, das in einigen wenigen Schritten erstellt werden kann.

Dadurch werden Persönlich identifizierende Informationen (PII) generiert, welche an das Thema Datenmangement andocken und für alle weiteren Marketingzwecke genutzt werden können. Die Downloads während Covid-19 spielen somit zusätzlich in das Leadmanagementkonzept von OBI ein.

3. INTERSPORT Austria GmbH

Intersport schaffte den Wechsel von stationärer Beratung auf Online-Beratung mit der Integration eines Online-Formulars auf der bestehenden Website. Mithilfe dieses Formulars ist es möglich ein telefonisches Gespräch mit einem Berater aus seinem Lieblingsstandort zu vereinbaren. Dabei stehen unterschiedliche Timeslots und Themenbereiche zur Verfügung. Die Besonderheit dieses Services ist die Möglichkeit einen direkten Verkaufsabschluss per Telefon zu tätigen.

Automatisierung ist der Schlüssel

Die drei vorangegangenen Lösungen für digitale Beratung haben etwas gemeinsam – dahinter liegen automatisierte Prozesse.

Dabei wird der gesamte Workflow:

» Terminfindung durch dynamischen Kalender

» Vorabbefragung

» Benachrichtigung bspw. Terminerinnerung

» Nachfassen des Termins

vollautomatisch durchgeführt. Eine manuelle Kette über ein einfaches Formular würde theoretisch funktionieren, ist aber nicht userfreundlich, ein großer Aufwand für die Unternehmen und kann zu Problemen in der Abwicklung führen. Zusätzlich ist es wichtig die Daten, die dabei generiert werden, strukturiert zu erfassen um den Kunden darauf aufbauend den besten Service zu bieten.

So geht’s richtig!

Soft Facts

- Information über den Gesprächspartner dem Mitarbeiter zur Verfügung stellen

- Interne Guidlines und Gesprächsleitfaden für Berater definieren

- Dokumentation des Beratungsgesprächs (im besten Fall direkt im Customer-Relationship-Management System)

- Puffer-Zonen von mindestens 10 Minuten zwischen den Terminen für den Mitarbeiter einplanen

- Follow-Up nach der Online-Beratung an den Kunden senden

-

-

- Bestellbestätigung

- Kundenbindung – Vielen Dank für das Gespräch!

- Versand eines Rabattcodes, Back in stock Angeboten

-

Hard Facts

- Website, App

- Klar definierte CTAs

- Integriertes Formular (PII)

- Termin-Kalender Funktion (Advanced)

- Geeignete Technologie passend zur Beratungsform

- CRM-System mit Marketing-Automation (Advanced)

Gekommen um zu bleiben?

Welche Vorteile könnte eine Online-Beratung nach Ende der Maßnahmen bedeuten:

+ Ergänzend zu Retail-Stores, kann Online als Verkaufsfläche dienen

+ Möglichkeit der Erklärung von komplexen Produkten im Online-Handel

+ Wachsendes Know-how im Umgang mit Online-Videos bei Kunden und Mitarbeitern

+ Service on demand: zeitlich flexible Online-Beratung (Terminkalender)

+ Up- und Crossselling im persönlichen Gespräch möglich

– Fehlendes Einkaufserlebnis für den Kunden

– Testmöglichkeit des Produktes nicht gegeben (Produktqualität)

– Abgabe von persönlichen Daten als Barriere für den Kunden (Datensicherheit)

Und jetzt?

Mit dem 14. April 2020 dürfen per Erlass Geschäfte unter 400 qm wieder öffnen. Dies bedeutet kleine Einzelhandelsunternehmen werden langsam aus der Schockstarre wieder erwachen. Ein Zurückkehren zur Normalität ist allerdings noch nicht absehbar. Einige sprechen sogar von der neuen Normalität. Trends zeigen, dass durch Covid-19 die Entwicklung hin zum Online-Handel um ein vielfaches beschleunigt wurde. Dies bedeutet: Es ist wichtig sich auch langfristig diesen neuen Gegebenheiten anzupassen.

Webshops und die ersten Online-Auftritte kleiner Marken werden die Dinge sein, die uns aus dieser Krise erhalten bleiben. Eine dieser Initiativen wurde durch die Plattform mein-handel.at bereits erfolgreich umgesetzt. Dabei wird Händlern die Möglichkeit geboten, schnell und einfach einen eigenen Online-Shop zu launchen.

Um dabei eine bestmögliche Customer Experience zu gewährleisten, haben wir unser Produktportfolio um die “506 Customer Service Plattform” kurz CSP erweitert. Damit liefern wir eine simple Automatisierungslösung, um mit Kunden Beratungsgespräche für erklärungsintensive Produkte per Videotelefonie durchführen zu können.

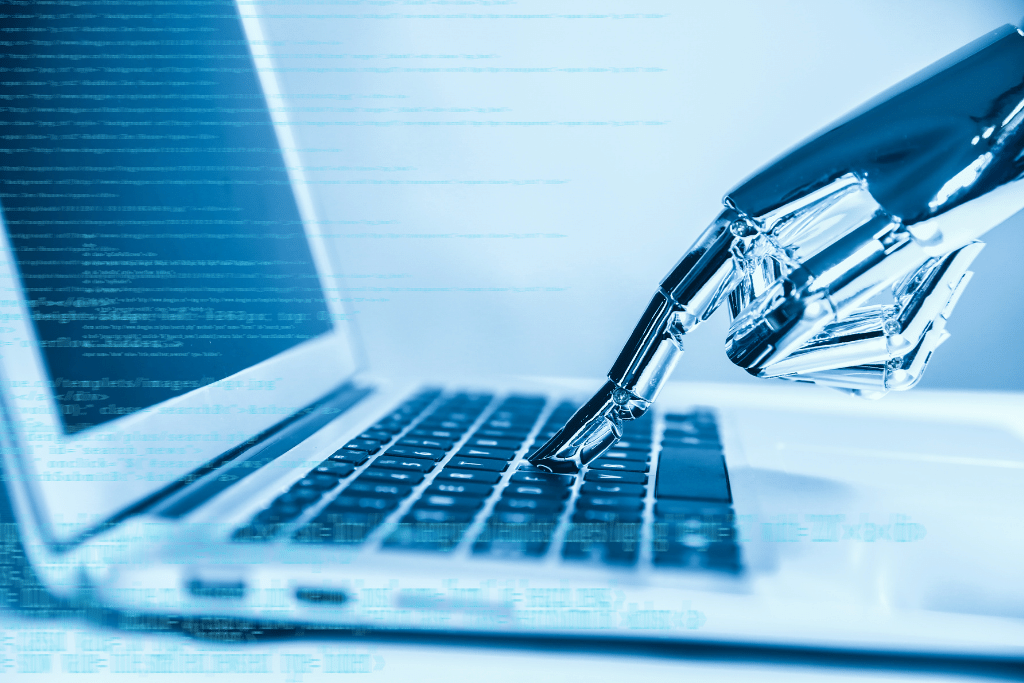

Die Nutzung von Machine Learning & Algorithmen zur Performance Optimierung ist schon lange state of the art im Performance Marketing. Die mit den Kampagnen generierten Daten werden verarbeitet und die Algorithmen der DSPs und Social Media Kanäle richten die Kampagnen bestmöglich auf das festgelegte Ziel aus.

Doch auch in anderen Teilbereichen von Performance Marketing Kampagnen wird immer mehr auf Automatisierung gesetzt. In diesem Blogbeitrag möchte ich im Speziellen auf drei Bereiche eingehen, mit welchen Kampagnen personalisiert, automatisiert und optimiert werden können: Dynamic Ads, Automatisierte Ausspielung mit Data Feeds und Optimierung mithilfe von Scripts.

Dynamic Ads

Zuerst sollten wir mal die fundamentale Frage klären: Was sind eigentlich dynamic Ads? Damit beschreibt man Werbemittel (meist Display Banner), deren Inhalt sich automatisch verändert, um jedem User den für ihn besten Content auszuspielen. Im Search Bereich gibt es als Pendant dazu Dynamic Text Ads, die sich automatisch Texte aus der Landing Page holen oder basierend auf den Suchanfragen variabel den Text anpassen (z.B. die richtige Schuhgröße). Im Display Bereich müssen die dynamischen Inhalte zur Verfügung gestellt werden. Im Werbemittel wird die Anordnung sowie die Animation festgelegt. Die Kombinationen werden aber dann automatisch für die jeweilige ZIelgruppe dynamisch generiert und in jedes vordefinierte Feld der richtige Inhalt geladen.

Im New Audience Marketing funktioniert das meist so, dass man für verschiedene Zielgruppen unterschiedliche Texte und Bilder erstellt und dann auf Basis der User das richtige Sujet ausgespielt wird. So könnte sich beispielsweise das Bild (oder auch Video) je nach Geschlecht und Altersgruppe verändern oder je nach Fortschritt in der Customer Journey der CTA angepasst werden. Dynamic Ads sind also das Produkt einer perfekten Zusammenarbeit von Mensch und Maschine. Der Mensch trägt die Vision, erstellt die richtigen Botschaften und plant die Strategie, die die Maschine dann optimal und in Echtzeit umsetzt.

Bei Retargeting wird meist mit einem Product Data Feed gearbeitet. Das kennt jedermann von den großen Online Shops. Man sieht sich einen Schuh an und danach wird man von eben diesem ein paar Tage lang verfolgt.

Wenn nun jedem User der für ihn relevante Inhalt angezeigt wird, kann natürlich auch das Kampagnenbudget effizienter eingesetzt werden. Ein Beispiel gefällig? In einer unserer Kampagnen, in der wir von allgemeinem Retargeting auf dynamic Product Retargeting upgegradet haben, konnten wir die CTR um etwa 40% erhöhen, während die Kosten pro Conversion gleichzeitig sogar um mehr als 50% gesunken sind. (und ja, mit dieser Conversion ist auch eine Kauf-Transaktion verbunden)

Automatisierte Ausspielung mit Data Feeds

Wenn Kampagnen auf Data Feeds aufbauend erstellt werden, kann man in der Automatisierung der Ausspielung sogar noch einen Schritt weiter gehen. Hier können ähnlich zum Dynamic Product Retargeting auch New Audience Kampagnen automatisiert werden. Hierzu müssen die richtigen Trigger und Regeln definiert, der Data Feed für die gewählte DSP entsprechend aufgebaut werden und voilà – die Kampagne passt automatisch das Produkt an den User an.

Product Data Feed

Der Product Data Feed ist quasi die Liste aller Produkte, die auf der Website verfügbar sind inklusive ihrer Eigenschaften. Sie kommen vor allem bei Online Shops zum Einsatz und stellen nicht nur die Basis für die Werbemittel, sondern auch für den Online Shop selbst dar. Dementsprechend werden sie in Echtzeit angepasst und sind immer up to date. Ein Produkt im Product Data Feed enthält alle wichtigen Produkt-Attribute sowie Lieferstand, Versandkosten etc.

Die automatisierte Ausspielung ist auch ein gutes Beispiel wie Mensch und Maschine optimal zusammenarbeiten können. Während die Ausspielung dann vollautomatisiert funktioniert und innerhalb des definierten Rahmens die Algorithmen mit Machine Learning die Kampagnen optimieren, sollte zu Beginn eine klare Strategie erarbeitet werden, welche Zielgruppe welche Ads sehen soll und welche Trigger verschiedene Inhalte auslösen sollen. Wenn der genaue Einblick in das Kaufverhalten der Zielgruppe noch fehlt, kann hier eine Datenanalyse- und -visualisierung eine gute Basis und Entscheidungsgrundlage liefern.

Optimierung mithilfe von Scripts

In der Kampagnenoptimierung können Scripts helfen, Tasks zu automatisieren, die ansonsten laufend händisch durchgeführt werden müssten. Zudem reagieren Scripts sofort auf veränderte Bedingungen, die der Mensch erst zeitverzögert bearbeiten könnte. So können mithilfe von Scripts Kampagnen auf Basis von Wetter- oder Temperaturdaten in Echtzeit adaptiert werden. Manuell wäre das nur schwer oder eben mit starker Zeitverzögerung möglich.

Basierend auf bestimmten Triggern, können Aktionen automatisch von den Scripts erledigt werden. Das bedeutet auch hier, dass zuerst einmal vom Menschen festgelegt werden sollte, welche Trigger welche Aktionen auslösen sollen. z.B. könnten vereinfacht gesagt bei Display Kampagnen alle Domains, auf denen die CTR einen gewissen Wert unterschreitet, automatisch ausgeschlossen werden. Bei Search Kampagnen könnten Keywords einfach pausiert werden, wenn sie nicht die gewünschte Performance liefern.

Aber Achtung! Nicht immer ist das, was die Maschine auf Basis der Regeln für das Beste hält, auch wirklich im Sinne der Kampagne. z.B.: Wenn eines der wichtigsten Keywords nicht performt, sollte wohl eher die Kampagne hinterfragt und optimiert werden, als einfach das Keyword auszuschließen. Es empfiehlt sich also ein Zusammenspiel der Kräfte. Was wir damit genau meinen, erklären wir anhand des Beispiels einer Search Kampagne: Mühsames Durchsuchen und Auflisten aller Keywords mit schlechter Performance kann von der Maschine übernommen werden. Der Mensch sieht sich diese Liste dann an und urteilt darüber, ob diese wirklich pausiert werden sollten oder doch lieber andere Maßnahmen ergriffen werden.

„Automatisierung nimmt in all unsere Lebensbereiche immer mehr Einfluss. Vor allem im Online Marketing, wo die vielen Daten für den Menschen kaum mehr handlebar sind, bringt sie klare Vorteile. So können beispielsweise mit dynamic Ads die User und Zielgruppen personalisiert angesprochen werden, was einzeln kaum durchführbar – geschweige denn bezahlbar – wäre. Die menschliche Komponente ist aber vor allem im strategischen Bereich in der Planung, Auswertung und finalen Entscheidung über einschneidende Veränderungen unabdingbar.“

NICOLA HELEKAL

HEAD OF PERFORMANCE MARKETING

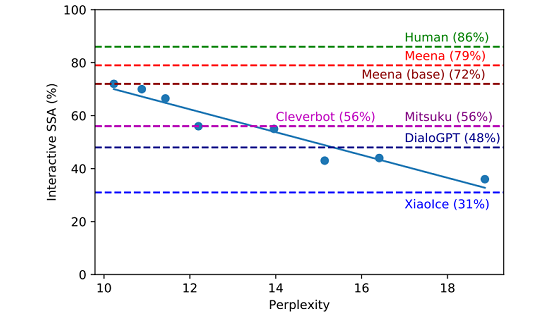

Herausragend an der Arbeit sind aber nicht nur die Resultate, sondern auch die Methoden, mit denen dies erreicht wurde. Diese zeigen auch den Weg auf, mit dem weitere Verbesserungen erzielt werden können. Es ist damit zu rechnen, dass analog zur Veröffentlichung von Googles Sprachmodell “BERT” (https://en.wikipedia.org/wiki/BERT_(language_model) ) ein Wettlauf für Weiterentwicklungen unter den Wissenschaftlern gestartet wurde, an dessen Ende Dialoge auf menschlichem Niveau möglich sein werden.

Quelle: www.pexels.com

Dieser Chatbot ist nicht nur auf ein Spezialgebiet optimiert

Auf dem “Preprint” Server “arXiv” kann seit Januar 2020 jeder die Arbeit “Towards a Human-like Open-Domain Chatbot” einsehen und lesen. Beschäftigt man sich näher damit, erkennt man die Dimension des Fortschritts, der hier auf diesem Gebiet erreicht wurde. Wie der Titel schon sagt, wird hier kein Chatbot für ein bestimmtes Wissensgebiet entwickelt, sondern eine Möglichkeit gezeigt, ein System zu schaffen, das quasi Universalwissen ähnlich wie ein Mensch hat und mit dem man sich über jedes Wissensgebiet unterhalten kann.

Viele zum Teil schon gut funktionierende Anwendungen von Chatbots sind auf einen Anwendungsfall oder ein Wissensgebiet fokussiert und mittels speziellen Regeln und dem Einsatz von Machine Learning für “Intent Matching” und “Entity Recognition” aufwändig auf einen Spezialfall hin getrimmt. Auf der anderen Seite sind bisherige Versuche von allgemeinen Chatbots noch sehr mäßig in der Qualität gewesen (z.B. Mitsuku).

Die Beispiel-Dialoge, die in der Arbeit und in größerer Sammlung auf einer Website dokumentiert sind, wirken beeindruckend. Das auf den Namen “Meena” getaufte System antwortet dabei nicht – wie in bisherigen Ansätzen oft zu sehen war – im Stile eines Politikers mit vagen und ausweichenden Formulierungen, um nur ja keine Fehler zu machen, sondern mit sehr spezifischen Antworten und trotzdem meist korrekt.

Ein Beispiel für einen Dialog mit “Meena”

Mensch: Hi!

Meena: Hi! How are you this fine evening?

Mensch: I’m doing well. it’s morning my time!

Meena: Good morning! What are your plans for today?

Mensch: Get my work done then watch a movie at home in the night

Meena: Sounds fun! What movie?

Mensch: I haven’t decided yet, perhaps an Oscarnominated one. any suggestion?

Meena: I’m not too familiar with recent Oscar winners, but I do know I wanted to see The Grand Budapest Hotel.

Mensch: ah, tell me about that movie!

Meena: It’s from the same director and writer as Moonrise Kingdom. Wes Anderson is pretty well known for making funny, colorful films. I’ve heard it’s pretty good.

Mensch: ha! I’ve searched on the internet and both movies are very colorful!

Meena: I’m looking forward to it. I love colorful movies

Meena kann den Kontext der Unterhaltungen erfassen

Was sofort auffällt ist, dass “Meena” bei einer Antwort auf den vorangegangenen Verlauf der Konversation eingeht, also den thematischen Kontext zuordnen kann und daher passende Antworten gibt. Dies ist eines der am schwierigsten zu lösenden Probleme bei der Entwicklung eines künstlichen Gesprächspartners, der wie ein Mensch wirken soll und wurde hier sehr gut gelöst.

Wie schon oben erwähnt, gibt “Meena” sehr spezifische Antworten je nach Frage und Kontext. Um dies zu erreichen haben die Autoren eine neue Methode entwickelt, um die Qualität von menschlichen und künstlichen Dialogen evaluieren zu können, die nicht nur die Korrektheit der Antworten mit einbezieht, sondern auch wie spezifisch sie sind. Mit dieser Metrik war es dann möglich, “Meena” besser zu evaluieren und optimieren.

“Brute Force” – “End to End” als Lösungsansatz

Noch beeindruckender als die Resultate finde ich die Methoden, mit denen diese erreicht wurden. Die Entwickler wählten eine riesige Neuronale Netz Architektur, eine verbesserte Version des sogenanntes Transformer Modells mit in diesem Fall 2.6 Milliarden Parametern und optimierten dieses dann mit einer gigantischen Menge an Trainingsdaten. Diese in Form von 341 GB an Text vorliegenden Daten wurden aus öffentlichen Dialogen aus den sozialen Medien gewonnen und geeignet gefiltert.

Der Lösungsansatz legt geradezu nahe, die Methode mit noch mehr Daten und noch leistungsfähigeren Modellen zu verbessern und mit weiteren Verfeinerungen der Auswahl der passenden Antworten noch näher an die menschliche Dialogfähigkeit heran zu bringen.

„Wir werden vermutlich noch im Jahr 2020 die ersten konkreten Implementierungen und Anwendungen von “Meena” im Web finden und in nicht zu ferner Zukunft Produkte in unserem Alltag finden, die dies einsetzen. “

PROF. (FH) DR. ANDREAS STÖCKL

HEAD OF CUSTOMER DATA MANAGEMENT